在人工智能 (AI) 运算需求爆炸性增长的背景下,AI芯片市场的竞争日趋白热化。Google自家研发的张量处理单元 (TPU) 需求不断攀升,对GPU大厂英伟达 (Nvidia) 构成显著威胁。有报告指出,Nvidia一个极其忠诚的客户Meta正考虑在其数据中心部署Google的TPU,此消息造成Nvidia的股价一度下跌。

面对市场变化,Nvidia通过社交媒体网络向Google表达了对其TPU成功赞美。然而,Nvidia在其Newsroom账号中表示,我们乐见Google的成功,因为他们在AI领域取得了巨大的进展,但我们也将持续向Google供货。之后,Nvidia随即强调其技术领先地位,声称Nvidia领先业界整整一代,是唯一可以运行所有AI模型,且能应用于所有运算场景的平台。Nvidia还进一步表示,相较于针对特定AI框架或功能设计的专用芯片 (ASICs,如TPU),Nvidia的产品提供了更高的性能、多功能性和可替换性。

尽管Nvidia自信满满,但Google代号Ironwood的第7代TPU仍展现出强劲的竞争力,不仅足以与Nvidia的Blackwell架构AI芯片一较高下,更在规模化上拥有巨大优势。Nvidia的机架服务器通常最多包含72个GPU,而Google的TPU集群则可从256颗芯片,扩展至多达9,216颗芯片。虽然Nvidia下一代的Vera Rubin加速器速度更快,但Google的优势在于规模化。因此,Google方面表示,他们正经历对其定制化TPU和Nvidia GPU两者的加速需求增长,并承诺将继续支持这两种产品。

目前,Meta据传正在洽谈从2027年开始在自家数据中心部署Google TPU。如果TPU被广泛采用,理论上可能对Nvidia的营收构成威胁。然而,Meta是否会或甚至能够选择TPU而非其他竞争平台,目前尚不明确。因为Google首先必须打破传统惯例,在公开市场上销售TPU,而非仅像历史上那样通过Google Cloud进行租赁。

其次,即使Google同意出售芯片给Meta,Meta仍将面临重大的系统集成挑战。Meta习惯于使用封包交换机,将数百或数千个基于AMD或Nvidia的GPU连接起来。然而,TPU的部署架构完全不同,它们是通过光电电路交换机 (OCS) 技术,将芯片连接成大型的环状网格。OCS与封包交换机的运行原理截然不同,通常需要不同的编程模型。

更大的挑战来自软件层面。Meta开发的深度学习库PyTorch虽然可以在TPU上运行,但TPU并不原生支持此框架,Meta需要应用一个名为PyTorch/XLA的转译层。即便拥有庞大的软件开发团队,Meta和Google当然可以克服这些挑战。然而,消息人士认为,如果报道中的会谈属实,更可能的场景是Meta正在讨论针对Google TPU对其Llama模型家族的推论优化。

事实上,推论工作所需的计算资源,比训练模型要少一个数量级,且推论受益于靠近终端用户以降低延迟并提高互动性。Meta通常在Hugging Face等存储库上发布其大型语言模型 (LLMs),供客户下载,并在包括Google TPU在内的各种加速器上运行。因此,Meta需要确保Llama在TPU上运行良好,以促进企业采用。但若目标仅是推论,企业可以直接从Google租用TPU来运行Llama,Meta本身并不需要拥有这些芯片。

就目前来看,Google的确观察到有更多竞争模型构建者对其TPU技术产生兴趣,其中包括Claude开发商Anthropic。Anthropic先前高度依赖Amazon Web Services(AWS) 定制化的Trainium AI加速器,但现正进行多样化布局。而且,Anthropic于2024年10月宣布,计划使用多达一百万颗TPU来训练并服务其下一代Claude模型。由于Google TPU和Amazon Trainium在计算集群中都采用网格拓扑结构,这降低了Anthropic从GPU迁移的成本。

Anthropic的策略并非单一。日前,Anthropic宣布与Microsoft和Nvidia创建战略伙伴关系。该合作包括Anthropic承诺购买价值高达300亿美元的Azure运算容量。因此,总体来说,当前AI市场的趋势显示,所有主要的AI参与者都在对冲风险,并与其他各方结成联盟。Google的Ironwood TPU所带来的威胁,可能比Nvidia愿意承认的还要庞大,这代表AI加速器市场正进入一个多方竞争、联盟交错的时代。

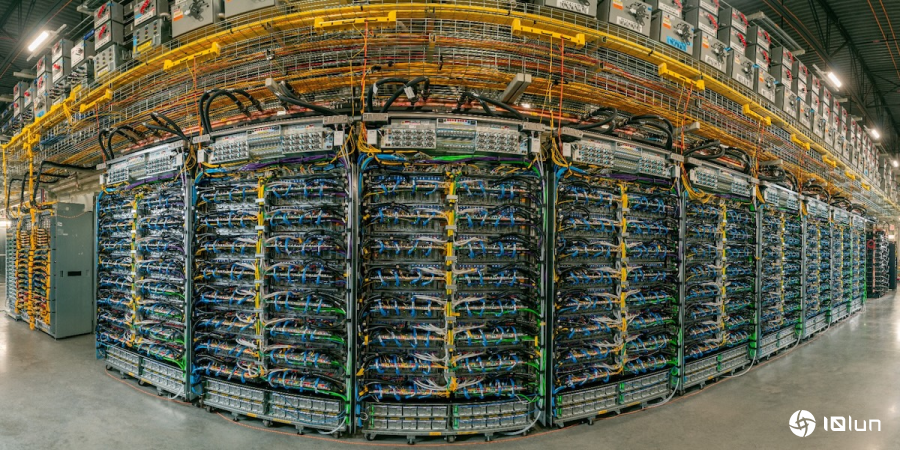

(首图来源:英伟达提供)

本网通过AI自动登载内容,本文转载自MSN,【提供者:十轮网科技资讯 | 作者:佚名】,仅代表原作者个人观点。本站旨在传播优质文章,无商业用途。如不想在本站展示可联系删除。